Życie

Naukowcy odkryli "kryptonit" sztucznej inteligencji, który doprowadza ją do szaleństwa

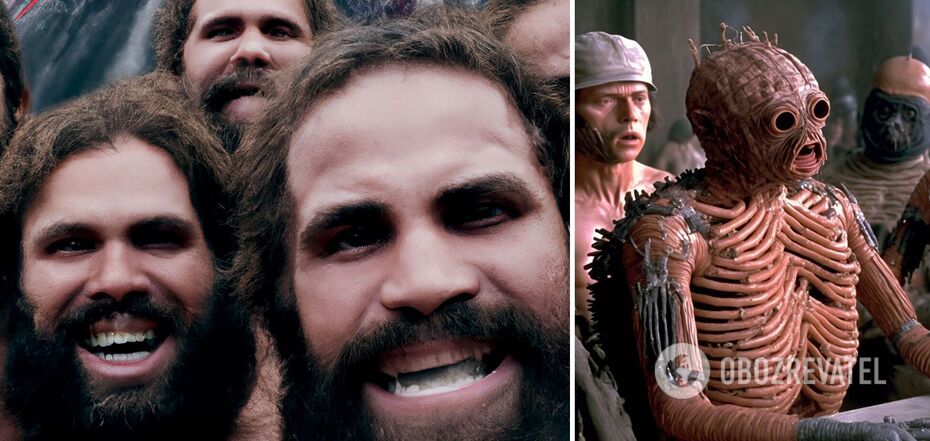

Okazuje się, że duże modele językowe i generatory obrazów (sztuczna inteligencja) dosłownie wariują, gdy próbuje się je trenować na samodzielnie generowanych treściach. Ten rodzaj ouroborosa (mitologicznego węża zwijającego się wokół Ziemi, chwytającego się za ogon) powoduje, że cyfrowy mózg modelu generatywnego ulega awarii.

Wynika to z badania przeprowadzonego przez naukowców z Rice University i Stanford University, dostępnego na stronie arXiv preprints. W ten sposób naukowcy odkryli rodzaj kryptonitu (kamienia, który zmienił Supermana w zwykłego człowieka, pozbawiając supermocy) sztucznej inteligencji.

Jak wyjaśnili naukowcy, znaczące postępy w algorytmach generatywnych sztucznej inteligencji dla obrazów, tekstu i innych typów danych skłoniły jej twórców do wykorzystania danych syntetycznych do trenowania modeli sztucznej inteligencji nowej generacji. Nikt jednak nie wiedział dokładnie, jak sztuczna inteligencja zareaguje, jeśli zostanie nakarmiona własnymi kreacjami.

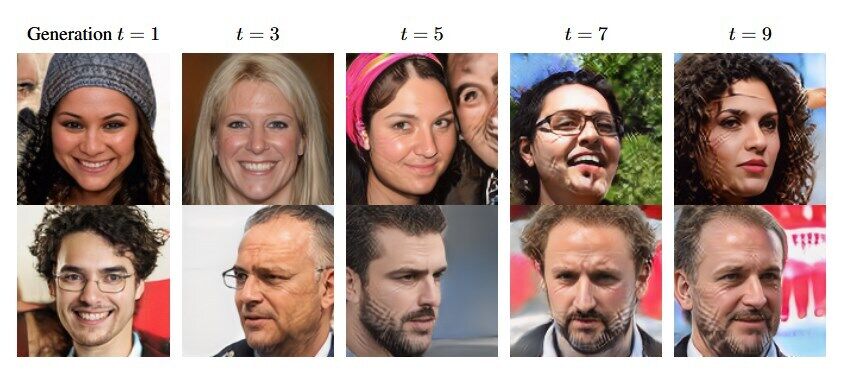

"Naszym głównym wnioskiem ze wszystkich scenariuszy jest to, że bez wystarczającej ilości świeżych danych ze świata rzeczywistego w każdej generacji pętli autofagii (samoabsorbującej), przyszłe modele generatywne są skazane na stopniowy spadek jakości (dokładności) lub różnorodności" - stwierdzili naukowcy w oświadczeniu po badaniu.

Stan wynikający z takiego działania nazwali MAD (bezpośrednie tłumaczenie - szaleństwo). Skrót pochodzi od Model Autophagy Disorder, co oznacza zaburzenie autofagii w modelu.

Prawdopodobnie mówienie o rewolucji AI można na chwilę wstrzymać, ponieważ bez świeżych prawdziwych danych lub, mówiąc prościej, oryginalnej ludzkiej pracy, wyniki AI znacznie się pogorszą.

Naukowcy byli w stanie ustalić, że przy wielokrotnym szkoleniu w zakresie treści syntetycznych dane wyjściowe sztucznej inteligencji stają się bardziej prymitywne, aż stają się monotonne.

Termin MAD, ukuty przez naukowców, odzwierciedla ten proces samoabsorpcji.

Jak wyszczególniono w artykule, testowany model sztucznej inteligencji przeszedł tylko pięć rund treningu z syntetyczną treścią, zanim zaczęły pojawiać się poważne problemy.

Sytuacja ta może być prawdziwym problemem dla OpenAI, które jest obecnie jednym z głównych graczy na rynku sztucznej inteligencji. Okazuje się bowiem, że firma wykorzystywała do trenowania swojej sztucznej inteligencji ogromne ilości tekstu generowanego przez internautów, często z naruszeniem praw autorskich.

A ponieważ istnieją już pozwy przeciwko OpenAI związane z nielegalnym wykorzystaniem treści, firma potrzebuje czegoś własnego, aby utrzymać sztuczną inteligencję. Ale teraz pojawiła się sytuacja, w której najłatwiejsza opcja, która mogła wszystko uratować - użycie czegoś, co zostało stworzone przez samą sztuczną inteligencję - nie przyniesie nic dobrego.

Wcześniej OBOZREVATEL opowiedział również o tym , co się stanie, gdy sztuczna inteligencja osiągnie osobliwość i czy będzie w stanie zabijać ludzi.

Subskrybuj kanały OBOZREVATEL w Telegramie, Viberze i Threads, aby być na bieżąco.